Alicia sufre un desmayo repentino en medio de una concurrida calle de una superpoblada metrópolis en alguna parte del mundo, en medio de una muchedumbre. Su pulsera detecta la caída repentina y manda un mensaje a la unidad de emergencia más cercana junto con su registro de identificación.

La unidad de emergencias recibe el aviso, y se pone en camino para el auxilio debido. En el trayecto, con el registro de identificación esta accede a la información médica de Alicia, y obtiene, enfermedades previas, indicadores básicos generales, alergias a medicamentos, etc. A la vez, se recaba la posición de los parámetros médicos de su ubicación actual que el dispositivo de muñeca se mantiene enviando.

Al llegar al sitio del suceso el paramédico tiene el instrumental necesario para la atención de primeros auxilios exactos que requiere Alicia, así como una clara idea de a qué prestar mayor cuidado. Realiza un escáner rápido de la huella digital junto con el reconocimiento facial, lo que confirma la identidad y procede a realizar los procedimientos planeados para llevarla prontamente a la mejor opción de centro asistencial indicado por el sistema, en razón de la urgencia del caso, su naturaleza, la distancia, el tráfico y la disponibilidad de atención.

Gracias a que su información se encontraba disponible para ser accedida por las distintas instancias participantes, Alicia fue atendida de manera rápida y precisa.

Estamos viviendo un momento en el que se está produciendo un punto de inflexión en lo que al concepto de privacidad concierne.

Pero, primero, revisemos definiciones buscando un punto de partida.

Según la RAE, privacidad se define, es su segunda acepción, como:

Ámbito de la vida privada que se tiene derecho a proteger de cualquier intromisión.

Y privado, en sus dos primeras acepciones:

1. adj. Que se ejecuta a vista de pocos, familiar y domésticamente, sin formalidad ni ceremonia alguna.

2. adj. Particular y personal de cada individuo.

Como era de esperarse, las definiciones académicas no ayudan mucho y es necesario adentrarse en otras especulaciones.

No hace tanto, escuche a Kade Crockford, Directora del Programa de Tecnología para la Libertad de la ACLU de Massachusetts, referirse a la privacidad como una cuestión de control. Y, aunque ella como activista y defensora que es, se refería a la perdida de la privacidad a través del reconocimiento facial, como herramienta de control de un grupo sobre otro para dominarlo, dándole una pequeña vuelta al enfoque, me parece que efectivamente la privacidad se tiene mucho que ver con el control, pero más que entre grupos rivales, es el control y las decisiones que debo tomar sobre mi mismo, acerca de cómo, con quién y para qué revelo aspectos propios a un tercero. Por lo menos, hasta ahora.

La privacidad, como concepto y como práctica va evolucionando. Siempre lo ha hecho sólo que ahora nos vemos forzados a cambiar y lo notamos más.

Athur Clarke y Stephen Baxter, tocan este tema en parte de su novela «Luz de otros días» en la que una nueva tecnología elimina completamente la privacidad y la humanidad debe adaptarse a esto. El concepto de intimo o privado desaparece tal como lo conocemos, sin embargo la actividad humana continúa tomando este punto de inflexión como una oportunidad para evolucionar como raza.

Es similar a lo que pasa en la actualidad con la masificación de internet y la avalancha de información provocada por redes sociales. Actualmente en la práctica nuestra actividad es de alguna manera capturada y guardada en la nube siendo prácticamente imposible evitarlo o poner candados.

Nuestra resistencia al cambio, hace que busquemos desesperadamente la forma de que nuestros datos no sean visibles para quienes no queramos, sin embargo de manera contradictoria queremos que estén disponibles permanentemente para nosotros y nuestros «aliados».

¿Porqué? para que no se haga mal uso de ellos, decimos. Pero… ¿qué entendemos por mal uso?

Volvamos al tema de Kade Crockford y su enfoque acerca de que la privacidad no es un tema de ocultar información, sino que es acerca del control.

De acuerdo, un buen punto que da que pensar. Queremos tener el control de nuestra propia información para que esté disponible para quien queramos o nos convenga en un determinado momento. Así todo estaría bien.

Pero, pongamos un caso. Camino por una calle oscura y, como es habitual (o debería serlo), no tengo ningún dispositivo de geolocalización activado… por seguridad, según pienso. Sin embargo de pronto sale un delincuente, me apunta con un arma y me pide que vayamos a un cajero para sacar dinero y robármelo. ¿Tengo tiempo de activar la geolocalización? ¿o le pido permiso a mi agresor?. Y una vez activado, ¿cómo envío esta señal a la policía o a alguien que pueda auxiliarme?.

Entonces, podemos pensar en tenerlo siempre activado. Ahora todos pueden saber donde estoy en cada momento…. también los delincuentes (oh no!). Es una especie de calle sin salida.

Bien, pensamos decididos entonces, le daremos a una «Inteligencia Artificial» la decisión de identificar cuando estoy en peligro y dar aviso. Perfecto, ¿Pero no estoy entonces delegando el control a esta tecnología y de acuerdo a la definición de privacidad = control, estoy perdiendo privacidad?

También podemos posicionarnos en el supuesto que si todo el mundo sabe siempre donde estoy, «los buenos» siempre sabrán y eso disuadirá a «los malos», por lo tanto si eliminamos el control (premisa del libro) y todo se equilibrará solo.

Todo puede pasar, y podemos imaginar lo que queramos, siempre tendremos un punto ciego que no podremos resolver porque estamos prejuiciados con mantener los conceptos como los manejamos hasta hoy y pocas veces nos abrimos a pensar hacia el futuro evolutivamente, y aún cuando creemos que lo hacemos, es en forma limitada. Lo único cierto es que los cambios, en este caso tecnológicos, nos hacen perder el control de nuestra propia información, y el tema es saber hacia dónde se mueve este y cuál es la nueva manera de tener control, antes de decidir no tenerlo.

Es un tema complejo, pero mi intención más allá de ofrecer alguna respuesta mágica, es indicar la necesidad de desprendernos del prejuicio de que debemos mantener el concepto de privacidad tal como lo hemos llevado hasta ahora, e ir un paso hacia adelante evolucionando nuestras ideas preconcebidas (o preconcedidas) y encontrar nuevos paradigmas para esto.

Posiblemente nuestros datos aun deberán ser privados, pero en público.

El debate está abierto.

En cambio las tácticas se enfocan en aspectos puntuales que se deben resolver en el camino de la ejecución de una estrategia. No tienen tanto en cuenta el entorno a largo plazo del problema, sino que en el problema puntual propiamente.

En cambio las tácticas se enfocan en aspectos puntuales que se deben resolver en el camino de la ejecución de una estrategia. No tienen tanto en cuenta el entorno a largo plazo del problema, sino que en el problema puntual propiamente.

Estamos viviendo una época en la que el peligro se ha vuelto una constante en nuestras vidas.

Estamos viviendo una época en la que el peligro se ha vuelto una constante en nuestras vidas.

Una de las lecciones que nos ha dejado el último ataque de ransomware, es que nunca estamos (ni estaremos, en mi opinión) preparados para un ataque de programas maliciosos.

Una de las lecciones que nos ha dejado el último ataque de ransomware, es que nunca estamos (ni estaremos, en mi opinión) preparados para un ataque de programas maliciosos.

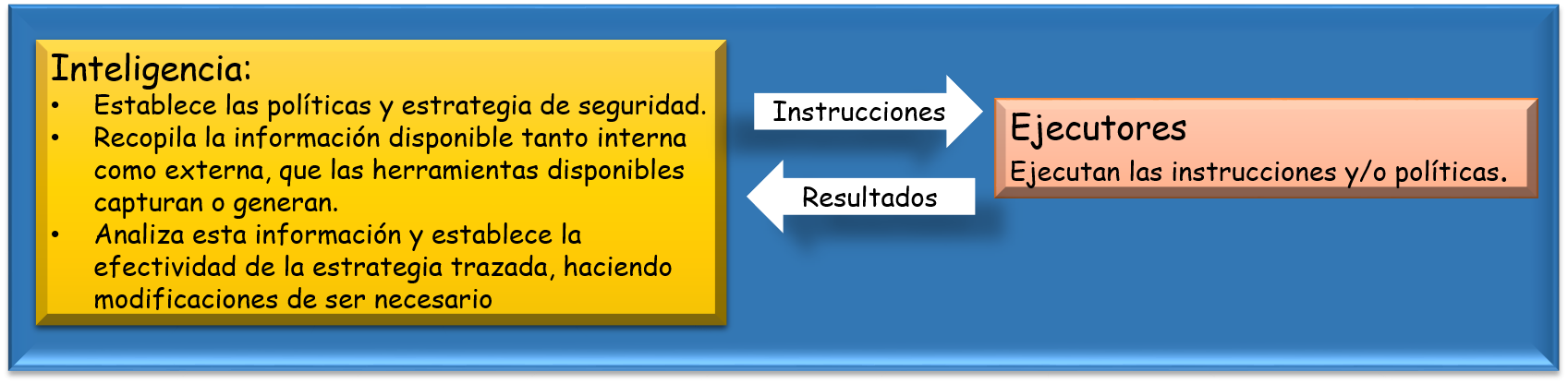

Cada vez que leo un artículo, o asisto a un encuentro de seguridad de la información (no me gusta el término de Ciberseguridad), siempre se plantea la necesidad de ver la seguridad como un todo orgánico, y en el que las partes que la componen interactúan entre sí. Incluso tenemos ya la figura del CISO, quien «es el responsable máximo en planificar, desarrollar, controlar y gestionar las políticas, procedimientos y acciones con el fin de mejorar la seguridad de la información dentro de sus pilares fundamentales de confidencialidad, integridad y disponibilidad.» (Wikipedia, 2016)

Cada vez que leo un artículo, o asisto a un encuentro de seguridad de la información (no me gusta el término de Ciberseguridad), siempre se plantea la necesidad de ver la seguridad como un todo orgánico, y en el que las partes que la componen interactúan entre sí. Incluso tenemos ya la figura del CISO, quien «es el responsable máximo en planificar, desarrollar, controlar y gestionar las políticas, procedimientos y acciones con el fin de mejorar la seguridad de la información dentro de sus pilares fundamentales de confidencialidad, integridad y disponibilidad.» (Wikipedia, 2016) En este punto, hay que decidir de acuerdo a la estrategia definida en los puntos anteriores, las herramientas que se deben implementar en cada nivel o combinación de niveles, es decir con qué vamos a contar : Firewall, Antivirus, Antispam; si se generarán roles de seguridad, políticas y procedimientos de upgrades y fixes, politicas y procedimientos de usuarios, si se requiere espejamiento de servidores, sites alternos,

En este punto, hay que decidir de acuerdo a la estrategia definida en los puntos anteriores, las herramientas que se deben implementar en cada nivel o combinación de niveles, es decir con qué vamos a contar : Firewall, Antivirus, Antispam; si se generarán roles de seguridad, políticas y procedimientos de upgrades y fixes, politicas y procedimientos de usuarios, si se requiere espejamiento de servidores, sites alternos,  redundancias, respaldos, los instaladores de las aplicaciones o sistemas, manuales y tutoriales, etc.

redundancias, respaldos, los instaladores de las aplicaciones o sistemas, manuales y tutoriales, etc.

Comentarios recientes